【GPT】开源 | 视觉和视觉语言任务中的自然语言解释模型NLX-GPT

实时分享CVPR、ECCV等会议,关注深度学习、自动驾驶领域,我们期待你的加入。点击上方“CNNer”,选择加“星标”或“置顶”精选干货,当日达。

获取完整原文和代码,公众号回复:11020384708

论文地址: http://arxiv.org/pdf/2203.05081v1.pdf

代码: 公众号回复:11020384708

来源: Vrije Universiteit Brussel

论文名称:NLX-GPT: A Model for Natural Language Explanations in Vision and Vision-Language Tasks

原文作者:Fawaz Sammani

内容提要

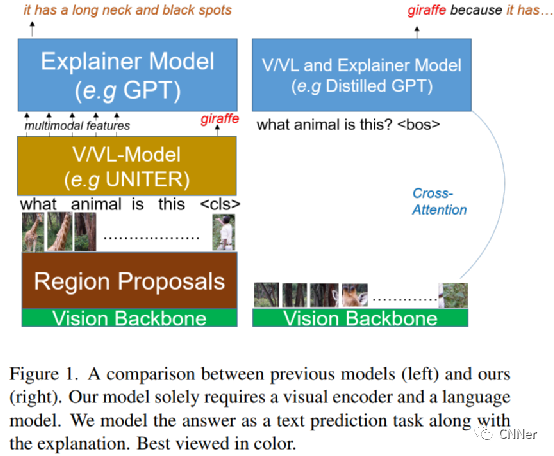

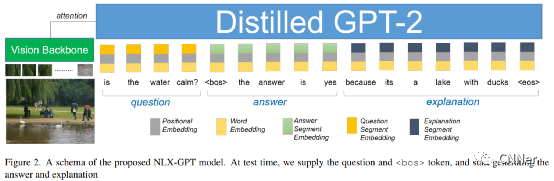

自然语言解释(NLE)模型旨在通过生成对人类友好的、高级的和细粒度的自然语言句子来解释黑盒系统的决策过程。当前的NLE模型通过语言模型(又名解释模型)(例如GPT)解释了视觉或视觉-语言模型(又名任务模型)的决策过程,例如VQA模型。除了任务模型需要额外的内存资源和推理时间外,任务模型和解释模型是完全独立的,这将解释从预测答案的推理过程中分离出来。我们引入NLX-GPT,这是一个通用的、紧凑的、忠实的语言模型,可以同时预测答案和解释答案。我们首先对图像-标题对的大规模数据进行预训练,以对图像进行一般理解,然后将答案与解释一起制定为文本预测任务。在没有区域建议和任务模型的情况下,我们的整体框架获得了更好的评估分数,包含的参数更少,比当前的SoA模型快15倍。然后,我们解决了评估解释的问题,这些解释可能在很多时候是通用的,有数据偏见的,可以有几种形式。因此,我们设计了2个新的评估措施:(1)解释-预测和(2)基于检索的攻击,这是一个不需要标签的自我评估框架。

主要框架及实验结果

声明:文章来自于网络,仅用于学习分享,版权归原作者所有,侵权请加上文微信联系删除。

分享最新的CVPR、ECCV、ICCV、IROS等人工智能论文,关注深度学习、自动驾驶领域。

长按关注▲ 长按加微信▲

备注:研究方向+地点+学校/公司+昵称,更快通过申请,长按加细分领域技术交流群,目前有细分领域:图像分割、图像目标检测、论文写作、车道检测、模型优化、目标跟踪、SLAM、点云处理(分割检测)、深度学习。

点个“在看”,让我知道你的爱